Tác giả: Dr. Young Jung, Flo Vinti, Sigit Priyanggoro, và Zeb Khan

Ngày đăng: ngày 01 tháng 5 năm 2025

Danh mục: Amazon Athena, Amazon Bedrock, Amazon EC2, Amazon Elastic Block Store (Amazon EBS), Amazon Elastic Kubernetes Service, Amazon Managed Grafana, Amazon SageMaker, Amazon VPC, Industries, Regions, Telecommunications

Giới thiệu

Tại MWC 2025, AWS đã công bố bản xem trước (preview) của một sản phẩm AWS Outposts racks mới dành cho các workload có thông lượng cao và sử dụng nhiều tài nguyên mạng. Chúng tôi vui mừng thông báo rằng sản phẩm này hiện đã phát hành rộng rãi (generally available) trong đợt ra mắt Outposts racks thế hệ thứ hai. Với lần ra mắt này, Outposts trao quyền cho các nhà cung cấp dịch vụ truyền thông (CSP) để tăng tốc hiện đại hóa các workload viễn thông tại chỗ (on-premises) của họ, chẳng hạn như chức năng User Plane Function (UPF) và Radio Access Network (RAN) Central Unit (CU) của mạng 5G.

Khối lượng công việc viễn thông bao gồm nhiều miền như RAN, lõi gói cho Internet băng thông rộng di động, Hệ thống con đa phương tiện IP (IMS) cho giao tiếp thoại và Hệ thống hỗ trợ hoạt động / Hệ thống hỗ trợ kinh doanh (OSS / BSS) để quản lý và vận hành. Mỗi miền này có các yêu cầu riêng liên quan đến hiệu suất, bảo mật, quyền riêng tư, độ bền dữ liệu, khả năng chịu lỗi và khả năng phục hồi. Do đó, CSP vận hành nhiều ngăn xếp cơ sở hạ tầng tại chỗ. Việc triển khai và quản lý vòng đời của các ngăn xếp riêng biệt này trên các vị trí địa lý khác nhau rất phức tạp, tốn kém và tốn thời gian. AWS giúp người dùng giải quyết những thách thức này bằng cách cung cấp một trải nghiệm đám mây xuyên suốt và liền mạch (seamless cloud continuum), cho phép người dùng vận hành các workload của họ trên khắp các AWS Region, AWS Local Zone và AWS Outposts tại chỗ, bằng cách sử dụng chung các dịch vụ và API của AWS.

Giá đỡ Outposts thế hệ thứ hai

Các giá đỡ Outposts thế hệ thứ hai được công bố vào ngày 29 tháng 4 năm 2025 có các phiên bản bare metal Amazon Elastic Compute Cloud (Amazon EC2) mới được gọi là bmn-cx2 với hạ tầng mạng bare metal (bare metal network fabric) hiệu năng cao. Điều này cho phép thông lượng cao và tốc độ gói mỗi giây (pps) cao để đáp ứng các yêu cầu của các workload sử dụng nhiều tài nguyên mạng. Các phiên bản bmn-cx2 mới được xây dựng trên cùng Hệ thống AWS Nitro, nền tảng sức mạnh cho các instance EC2 trong AWS Region và AWS Local Zone hiện nay. Với bộ xử lý Intel Xeon Scalable thế hệ thứ tư (Sapphire Rapids), các instance bmn-cx2 có tỷ lệ bộ nhớ trên vCPU là 5:1. Không chỉ là băng thông mạng thông thường, chúng còn có các thẻ tăng tốc mạng chuyên dụng được thiết kế cho khối lượng công việc tại chỗ nhạy cảm với độ trễ và thông lượng cao nhất. Ngày nay, loại bmn-cx2.metal-48xl với các thông số kỹ thuật sau đã có sẵn.

| Kích thước instance | vCPU | Bộ nhớ (GiB) | Lưu trữ phiên bản (GB) | Băng thông mạng (Gbps) | Card mạng tăng tốc | Băng thông mạng tăng tốc (Gbps) |

| bmn-cx2.metal-48xl | 192 | 1024 GiB | 4x 4000 NVMe | 50 | 2 | 800 |

Bảng 1: Thông số kỹ thuật của instance bmn-cx2.metal-48xl

Card mạng tăng tốc trong các phiên bản bmn-cx2 không chỉ cung cấp băng thông mạng bare metal lên đến 800 Gbps, hoạt động ở tốc độ gần như tối đa của đường truyền (near line rate) mà còn hỗ trợ mạng L2 như VLAN, đa hướng và Giao thức thời gian chính xác (PTP) dựa trên phần cứng để cung cấp các tính năng cụ thể cho khối lượng công việc viễn thông như phân đoạn mạng dựa trên L2 và phân phối chính xác thời gian và tần số qua mạng dựa trên gói.

Khách hàng sử dụng phiên bản bmn-cx2 có thể mở rộng các lợi ích về bảo mật và hiệu suất nâng cao của Hệ thống AWS Nitro cho các giá đỡ Outposts, đồng thời sử dụng mạng bare metal để phù hợp với các tính năng và nhu cầu hiệu suất của khối lượng công việc viễn thông. Các khối lượng công việc này chạy ở các vị trí mà hàng trăm nghìn người dùng di động tạo ra thông lượng mạng hàng trăm Gigabit mỗi giây (Gbps) đến Terabit mỗi giây (Tbps).

Các rack AWS Outposts này cũng tích hợp liền mạch với các dịch vụ AWS khác trong AWS Region và AWS Local Zone để có trải nghiệm cloud nhất quán. Ví dụ: CSP có thể sử dụng AWS Telco Network Builder (TNB) để hợp lý hóa việc tự động hóa và quản lý vòng đời của cơ sở hạ tầng Đám mây AWS như Amazon Virtual Private Cloud (Amazon VPC), mạng con, cụm Amazon Elastic Kubernetes Service (Amazon EKS) và Chức năng mạng trong bộ chứa (CNF) trên nhiều trung tâm dữ liệu. CSP có thể sử dụng các dịch vụ như Amazon CloudWatch, Amazon Managed Service for Prometheus và Amazon Managed Grafana để có khả năng quan sát. Hơn nữa, CSP có thể sử dụng các dịch vụ phân tích và máy học (ML) của AWS như Amazon Athena, Amazon Bedrock và Amazon SageMaker để hợp lý hóa hoạt động với phân tích và tương quan dữ liệu chỉ số mạng.

Các giá đỡ Outposts dành cho khối lượng công việc tại chỗ có thông lượng cao và sử dụng nhiều mạng cho phép CSP triển khai phần mềm Nhà cung cấp phần mềm độc lập (ISV) bằng cách sử dụng Amazon EKS và các tiện ích bổ sung EKS đã được xác thực trước cần thiết để tự động hóa việc triển khai, quản lý và thay đổi quy mô các chức năng mạng 5G dựa trên vi dịch vụ. Các tiện ích bổ sung Amazon EKS này rất cần thiết cho khối lượng công việc mạng viễn thông và bao gồm: 1) Multus, Giao diện mạng bộ chứa (CNI) cho phép người dùng gắn nhiều giao diện mạng và áp dụng cấu hình mạng nâng cao cho các chức năng mạng của họ. Hỗ trợ Multus cho phép các ISV cấu hình các cluster Amazon EKS của họ để chạy các pod Kubernetes multi-homed (gắn vào nhiều giao diện mạng) nhằm phục vụ việc phân đoạn mạng. 2) Single Root IO Virtualization (SR-IOV) CNI để cung cấp cho các pod những giao diện mạng chuyên dụng bằng cách sử dụng các tính năng SR-IOV của bộ điều hợp mạng bare metal vật lý (underlying). Hỗ trợ SR-IOV CNI rất quan trọng đối với khối lượng công việc mạng viễn thông để đạt được khả năng thông lượng cao được cung cấp bởi các phiên bản bare metal Amazon EC2. 3) Whereabouts, một plugin CNI Quản lý Địa chỉ IP (IPAM) để gán động địa chỉ IP cho các giao diện mạng do CNI tạo ra. 4) Longhorn để hỗ trợ các yêu cầu về khối lượng liên tục ReadWriteMany (RWX), cũng như ReadWriteOnce (RWO) do Amazon Elastic Block Store (Amazon EBS) cung cấp. Với sự sẵn có của các tiện ích bổ sung này, CSP có thể triển khai khối lượng công việc 5G Core, IMS và RAN CU đầu cuối như mặt phẳng điều khiển và chức năng mạng mặt phẳng người dùng.

Giá đỡ Outposts thế hệ thứ hai cho phép CSP tạo nhiều cấu hình để giải quyết các yêu cầu về điện toán, lưu trữ, bộ nhớ và mạng của một tập hợp khối lượng công việc đa dạng bằng cách sử dụng cùng một cơ sở hạ tầng. Ví dụ: CSP có thể triển khai Outposts với bất kỳ sự kết hợp nào giữa các phiên bản EC2 bmn-cx2, mục đích chung, tối ưu hóa điện toán và tối ưu hóa bộ nhớ để triển khai khối lượng công việc trên các miền viễn thông đã đề cập trước đó. Điều này cho phép CSP giải quyết sự phức tạp về triển khai, vận hành và tích hợp của việc quản lý các triển khai tại chỗ khác nhau trên toàn bộ cấu trúc liên kết của mạng của họ, chẳng hạn như mạng truyền tải, RAN, Core và Voice. Bên cạnh việc kết hợp các loại phiên bản EC2, CSP có thể bắt đầu với việc triển khai Outposts hai giá đỡ nhỏ và mở rộng quy mô lên hàng chục giá đỡ.

Các mẫu kiến trúc sử dụng giá đỡ Outposts thế hệ thứ hai

Trong phần này, một số mẫu kiến trúc để triển khai khối lượng công việc viễn thông trên AWS Cloud continuum được trình bày. Tùy thuộc vào các yếu tố như trường hợp sử dụng, yêu cầu quy định và triển khai hiện có, CSP có thể chọn một hoặc kết hợp bất kỳ mô hình triển khai nào được trình bày trong các phần sau.

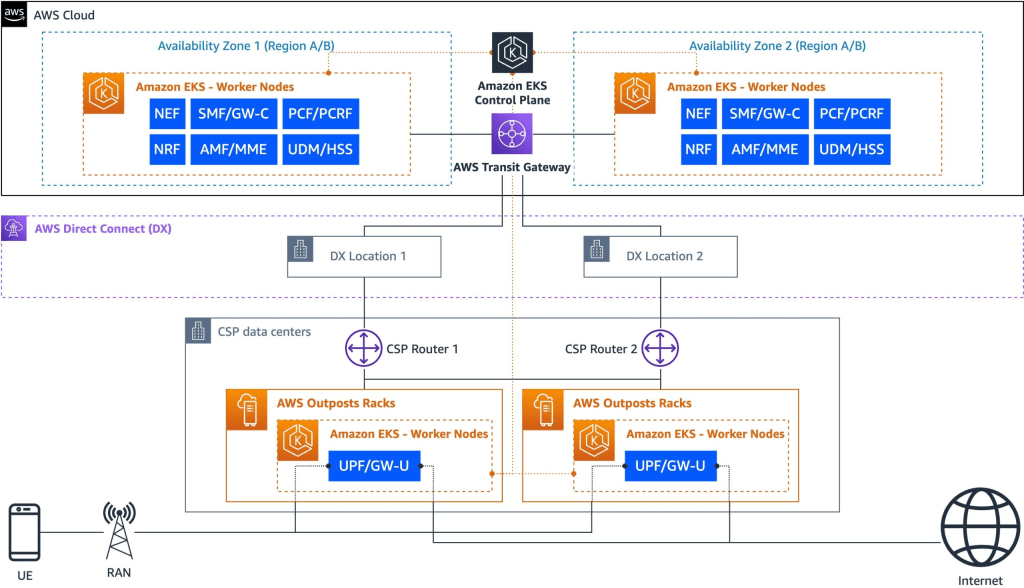

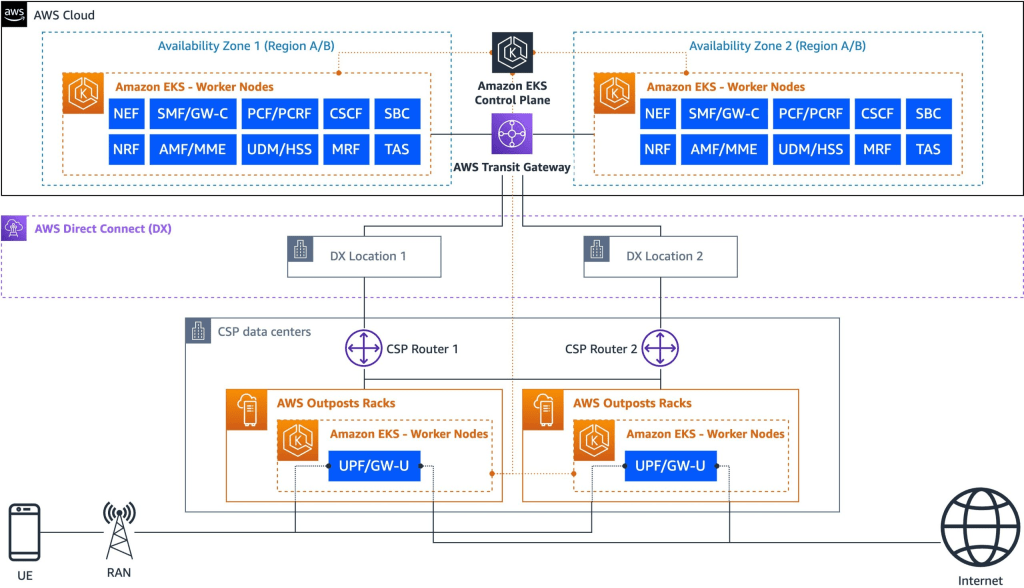

Tình huống 1: Triển khai lõi gói kết hợp trên các AWS Region và Outposts

Đối với các CSP có thuê bao được phân phối trên các vị trí tại chỗ vì các lý do như độ trễ truyền tải được tối ưu hóa và khoảng cách với các điểm ngang hàng internet/mạng phân phối nội dung (CDN), Outposts cung cấp khả năng triển khai khối lượng công việc sử dụng nhiều mạng như UPF gần các vị trí tại chỗ này hơn trong khi chạy khối lượng công việc mặt phẳng điều khiển trong AWS Region để đạt được các kiến trúc có hiệu năng cao và khả năng phục hồi tốt (xem hình dưới đây).

Các thông số kỹ thuật của Dự án Đối tác Thế hệ thứ 3 (3GPP) xác định các cơ chế lựa chọn chức năng mạng có thể được áp dụng trong kiến trúc lai này để kiểm soát chi tiết phân phối lưu lượng truy cập. Ví dụ: Chức năng quản lý truy cập và di động (AMF) có thể chọn Chức năng quản lý phiên (SMF) dựa trên dữ liệu thuê bao, thông tin lát cắt mạng và mạng dữ liệu được yêu cầu như internet.

Việc triển khai trên nhiều Availability Zone (AZ) và/hoặc nhiều AWS Region cho phép CSP đạt được độ sẵn sàng cao ở một đầu và mặt khác sử dụng các quy trình 3GPP tiêu chuẩn để điều khiển lưu lượng thông minh đến một hoặc nhiều UPF có sẵn được triển khai trên Outposts ở các địa điểm khác nhau. Điều này dựa trên các đặc điểm như tải hiện tại, độ trễ, trường hợp sử dụng và các thông số dành riêng cho dịch vụ.

AWS Outposts hỗ trợ nhiều loại cấu hình dự phòng, trong đó N+K là một dạng điển hình. Nó đảm bảo tính khả dụng của dịch vụ ngay cả khi K Outposts bị lỗi đồng thời. Ví dụ, trong mô hình N+2, hệ thống có thể chịu được sự cố của tối đa hai Outposts. Cơ chế dự phòng này có thể trải rộng trên nhiều Outposts ở cùng một vị trí địa lý hoặc khác nhau để đạt được các mục tiêu khả năng phục hồi và tính khả dụng mong muốn.

Hình 1: Triển khai lõi gói kết hợp trên AWS Region và AWS Outposts

Kiến trúc kết hợp dựa trên AWS Region và AWS Outposts cho phép CSP tối ưu hóa cả hiệu suất và hiệu quả hoạt động bằng cách đặt các UPF gần người đăng ký trong khi sử dụng khả năng mở rộng và độ tin cậy của AWS Region cho các chức năng mặt phẳng điều khiển.

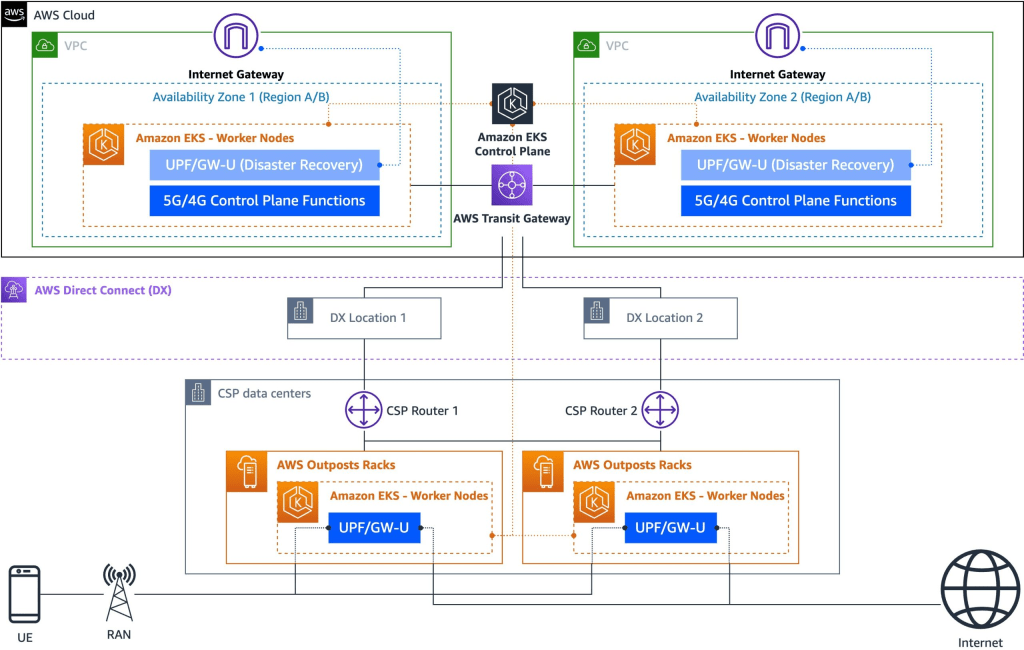

Tình huống 2: Triển khai lõi gói kết hợp trên các AWS Region và AWS Outposts với phương án phục hồi sau thảm họa tại AWS Region

AWS Tương tự như kịch bản trước, kiến trúc này triển khai khối lượng công việc mặt phẳng điều khiển trong một hoặc nhiều AWS Region trong khi phân phối UPF trên nhiều Outposts. Tuy nhiên, kịch bản này bổ sung chiến lược phục hồi sau thảm họa sử dụng AWS Region làm vị trí để mở rộng dung lượng UPF, như có thể thấy trong hình sau.

Trong các hoạt động bình thường, UPF trên Outposts xử lý lưu lượng thuê bao gần biên mạng, giảm thiểu độ trễ và tối ưu hóa backhaul. Các UPF phân tán tuân theo các mô hình dự phòng tiêu chuẩn để xử lý các lỗi thông thường. Tuy nhiên, trong các tình huống thảm khốc khi nhiều Outpost không khả dụng đồng thời do thiên tai, mất điện, cắt cáp quang hoặc các sự cố lớn khác, kiến trúc này cho phép khôi phục nhanh chóng bằng cách kích hoạt dung lượng UPF không hoạt động hoặc theo yêu cầu trong các AWS Region. Điều này bao gồm thành phần VPC có khả năng mở rộng theo chiều ngang, dự phòng và có độ sẵn sàng cao được gọi là Internet gateway (IGW), hoạt động như một phương án thay thế cho các điểm kết nối Internet (internet breakout) tại chỗ. Việc kết hợp IGW với tính năng Bring Your Own IP (BYOIP) của Amazon EC2 cho phép CSP đưa một phần hoặc toàn bộ dải địa chỉ IPv4 hoặc IPv6 có thể định tuyến công khai của họ từ mạng tại chỗ đến tài khoản AWS của họ và quảng cáo trên internet thông qua AWS. Đổi lại, điều này cho phép họ sử dụng các địa chỉ này làm IP thiết bị người dùng (UEIP).

Hình 2: Triển khai lõi gói kết hợp trên AWS Region và AWS Outposts với phương án phục hồi sau thảm họa tại AWS Region

Mặc dù kiến trúc này có thể gây ra độ trễ cao hơn vì lưu lượng truy cập có thể đi qua các đường dẫn dài hơn đến các UPF dựa trên AWS Region, nhưng kiến trúc này cung cấp chính sách bảo hiểm hiệu quả về chi phí chống lại các lỗi vị trí biên nghiêm trọng.

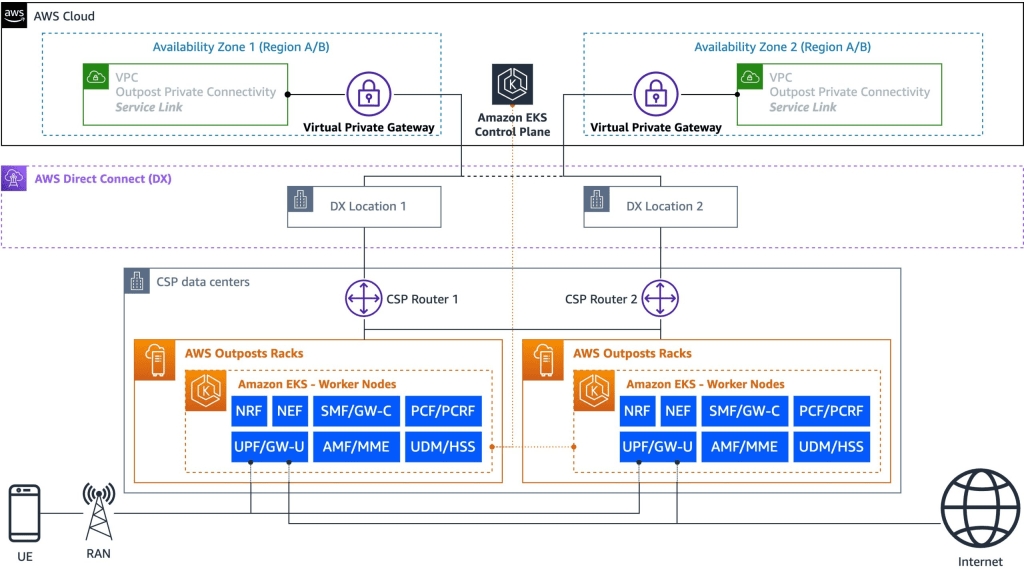

Tình huống 3: Hoàn thành triển khai lõi gói trên Outposts tại cơ sở

khách hàng Đối với các trường hợp không có AWS Region nào trong khu vực CSP quan tâm hoặc nơi cư trú dữ liệu yêu cầu cả mặt phẳng điều khiển và khối lượng công việc mặt phẳng người dùng được đặt tại chỗ, CSP có thể sử dụng Outposts để lưu trữ cả mặt phẳng điều khiển và UPF như được mô tả trong hình sau. Được xây dựng dựa trên khả năng kết hợp các loại phiên bản EC2 khác nhau trong cùng một giá đỡ Outposts, các chức năng mặt phẳng điều khiển có thể được triển khai trên các phiên bản EC2 thông thường như dòng phiên bản C7i trong khi khối lượng công việc mặt phẳng người dùng chạy trên các phiên bản bmn-cx2.

Mô hình này cho phép CSP đáp ứng các yêu cầu nhất định liên quan đến việc lưu giữ dữ liệu thuê bao và hoạt động mạng trong các khu vực pháp lý cụ thể trong khi vẫn sử dụng cơ sở hạ tầng và dịch vụ AWS. Kiến trúc này tối ưu hóa hiệu suất cho các dịch vụ cục bộ và duy trì tính nhất quán trong hoạt động thông qua các công cụ quản lý, API và dịch vụ AWS tương tự được sử dụng trong các AWS Region.

Để có khả năng phục hồi, CSP thường triển khai kiến trúc này trên nhiều vị trí vật lý, mỗi vị trí có triển khai Outposts riêng. Điều này tạo ra một đám mây biên phân tán duy trì tính liên tục của dịch vụ ngay cả khi một trang web gặp sự cố ngừng hoạt động. Các chức năng mặt phẳng điều khiển có thể được cấu hình ở chế độ hoạt động-hoạt động hoặc hoạt động-chờ trên các trang web này, với cơ chế chuyển đổi dự phòng tự động để đảm bảo dịch vụ liên tục.

Hình 3: Hoàn thành triển khai lõi gói Outposts tại cơ sở người dùng

Bên cạnh băng thông rộng di động nâng cao (eMBB), các trường hợp sử dụng khác mà kiến trúc này phục vụ bao gồm mạng riêng, truy cập không dây cố định và truyền thông độ trễ thấp cực kỳ đáng tin cậy (URLLC).

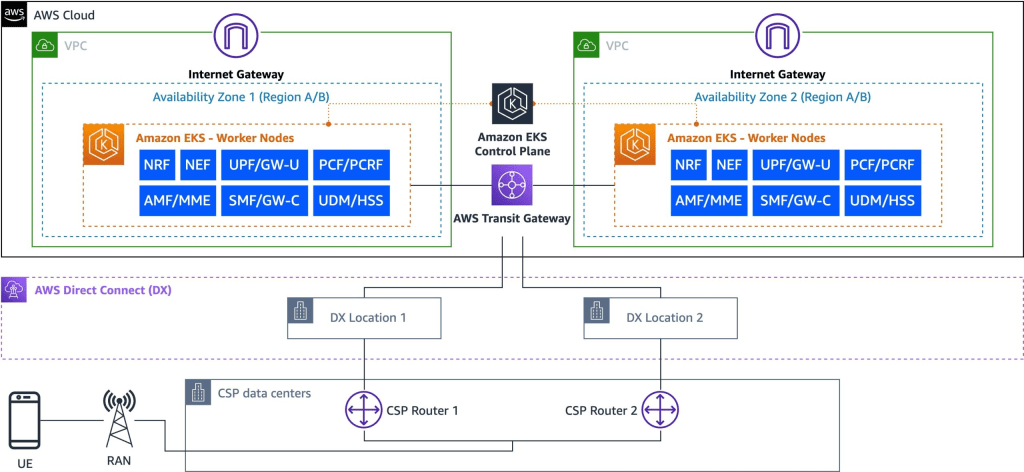

Tình huống 4: Triển khai lõi gói dựa trên AWS Region

Trong trường hợp này, lõi gói hoàn chỉnh được triển khai trong (các) AWS Region.

Cả khối lượng công việc mặt phẳng điều khiển và mặt phẳng người dùng đều được triển khai dự phòng trên nhiều AZ và/hoặc AWS Region như thể hiện trong hình sau.

Đối với triển khai lõi gói 5G/4G, các chức năng mặt phẳng điều khiển như Chức năng quản lý truy cập và di động (AMF)/Thực thể quản lý di động (MME), Chức năng quản lý phiên (SMF)/SPGW-C, Chức năng kiểm soát chính sách (PCF)/Chức năng quy tắc chính sách và tính phí (PCRF), Chức năng kho lưu trữ mạng (NRF), Chức năng tiếp xúc mạng (NEF), Quản lý dữ liệu hợp nhất (UDM)/Máy chủ thuê bao gia đình (HSS) và các chức năng khác được triển khai ít nhất trên hai AZ.

Đối với các trường hợp sử dụng mà khoảng cách tối thiểu giữa các trung tâm dữ liệu phải vượt quá khoảng cách điển hình giữa hai AWS AZ (cách nhau tối đa 60 dặm/100 km), CSP có thể triển khai trên nhiều AWS Region. Tương tự, UPF được triển khai trong một cụm dự phòng địa lý có thể chống chịu được các sự cố có ảnh hưởng trên phạm vi toàn Availability Zone và toàn AWS Region. Tại các khu vực địa lý có sẵn cả AWS Region và AWS Outposts, các CSP thường ưu tiên những kiến trúc hybrid đã được giải thích ở trên để có một thiết kế tối ưu, cân bằng giữa khả năng phục hồi của AWS Region, sự gần gũi của UPF với các điểm kết nối Internet (internet breakouts), độ trễ và chi phí truyền dữ liệu.

Hình 4: Triển khai lõi gói dựa trên AWS Region

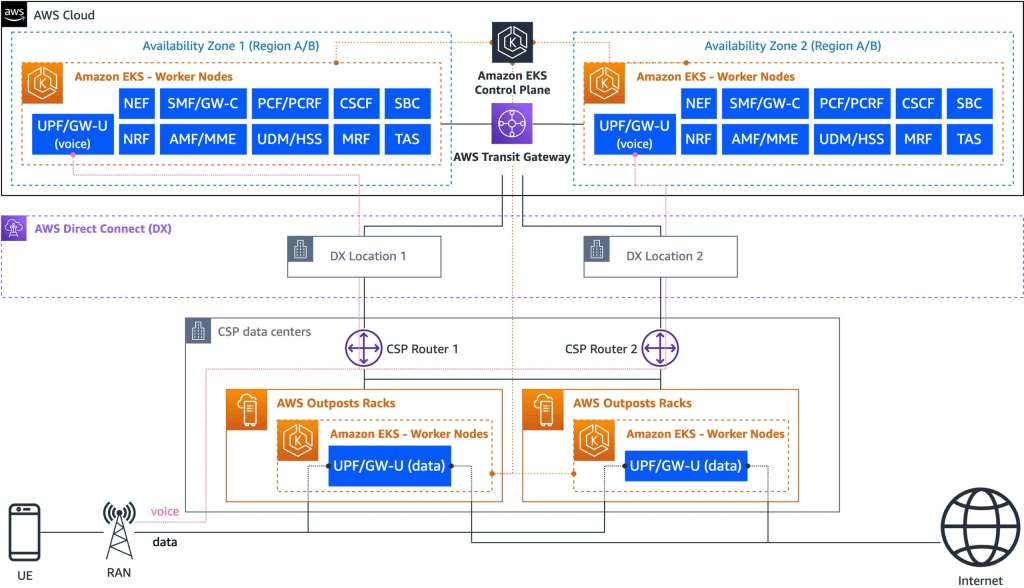

Tình huống 5: IMS dựa trên AWS Region với triển khai lõi

gói kết hợp Kịch bản này trình bày kiến trúc trong đó IMS cho các dịch vụ thoại được triển khai trong các AWS Region cùng với các chức năng mặt phẳng điều khiển lõi 5G/4G, trong khi UPF được phân phối trên nhiều Outposts ở biên.

Cách tiếp cận kết hợp này tạo ra hai mô hình lưu lượng chính như thể hiện trong hình sau: lưu lượng internet/dữ liệu đi thẳng từ UPF ra internet thông qua các điểm kết nối Internet cục bộ (local breakout points), trong khi lưu lượng thoại và tín hiệu giữa lõi 5G/4G và IMS đi qua kết nối giữa Outposts và AWS Region.

Trong kiến trúc này, các chức năng mặt phẳng điều khiển như AMF và SMF được triển khai trong các AWS Region để quản lý tập trung, trong khi UPF được đặt một cách chiến lược trên Outposts gần người đăng ký hơn. Các thành phần IMS bao gồm nhưng không giới hạn ở Chức năng kiểm soát phiên gọi (CSCF), Bộ điều khiển biên phiên (SBC), Chức năng tài nguyên phương tiện (MRF) và Máy chủ ứng dụng điện thoại (TAS). Chúng được triển khai ở các AWS Region để hưởng lợi từ tính linh hoạt và độ sẵn sàng cao của đám mây.

Hình 5: IMS dựa trên AWS Region với triển khai lõi gói kết hợp

Đối với các CSP chuyển đổi từ mạng cũ, mô hình này cung cấp một cách tiếp cận thực tế để hiện đại hóa. Nó cho phép họ di chuyển các dịch vụ thoại lên đám mây trong khi vẫn duy trì hiệu suất dịch vụ dữ liệu tối ưu thông qua các UPF được triển khai biên. Kiến trúc này đặc biệt có lợi cho các CSP đang tìm cách chuyển đổi dần cơ sở hạ tầng mạng của họ mà không làm gián đoạn các dịch vụ hiện có.

Tình huống 6: IMS dựa trên AWS Region với giọng nói UPF và dữ liệu UPF dựa trên Outposts

Được xây dựng dựa trên kịch bản trước, mô hình này giới thiệu cách tiếp cận chi tiết để triển khai UPF bằng cách tách các phiên bản UPF dựa trên loại lưu lượng truy cập.

Trong mô hình này, các chức năng IMS và mặt phẳng điều khiển vẫn ở trong AWS Region, nhưng mặt phẳng người dùng được phân chia: Phiên bản UPF xử lý lưu lượng thoại được triển khai trong AWS Region cùng với IMS, trong khi các phiên bản UPF xử lý lưu lượng dữ liệu được triển khai trên Outposts ở biên. Lưu lượng thoại được xác định và định tuyến đến UPF đặt tại AWS Region, có kết nối tối ưu hóa với các thành phần IMS, trong khi lưu lượng truy cập liên quan đến internet được xử lý bởi UPF được triển khai biên trên Outposts (quan sát hình sau).

Việc đặt các phiên bản UPF dành riêng cho giọng nói ở AWS Region gần IMS cho phép kiến trúc này giảm thiểu độ trễ khi báo hiệu giữa các thành phần UPF và IMS. Việc tối ưu hóa này cũng có thể nâng cao thời gian thiết lập cuộc gọi và cải thiện quản lý dịch vụ thoại tổng thể. Hơn nữa, cách tiếp cận này làm giảm lượng lưu lượng tín hiệu đi qua giữa các AWS Region và AWS Outposts.

Hình 6: IMS với giọng nói UPF trong AWS Region và dữ liệu UPF trong Outposts

Cả Kịch bản 5 và Kịch bản 6 đều cho phép CSP sử dụng các khả năng kết nối mạng hiệu suất cao của Outposts với các phiên bản bmn-cx2, trong khi Tình huống 6 bổ sung tính linh hoạt để tối ưu hóa việc xử lý lưu lượng thoại thông qua triển khai UPF dựa trên AWS Region. Cách tiếp cận này cho phép CSP điều chỉnh việc triển khai cho phù hợp với cơ sở hạ tầng hiện có của họ, đồng thời duy trì lợi ích của trải nghiệm cloud nhất quán của AWS trên các AWS Region và AWS Outposts.

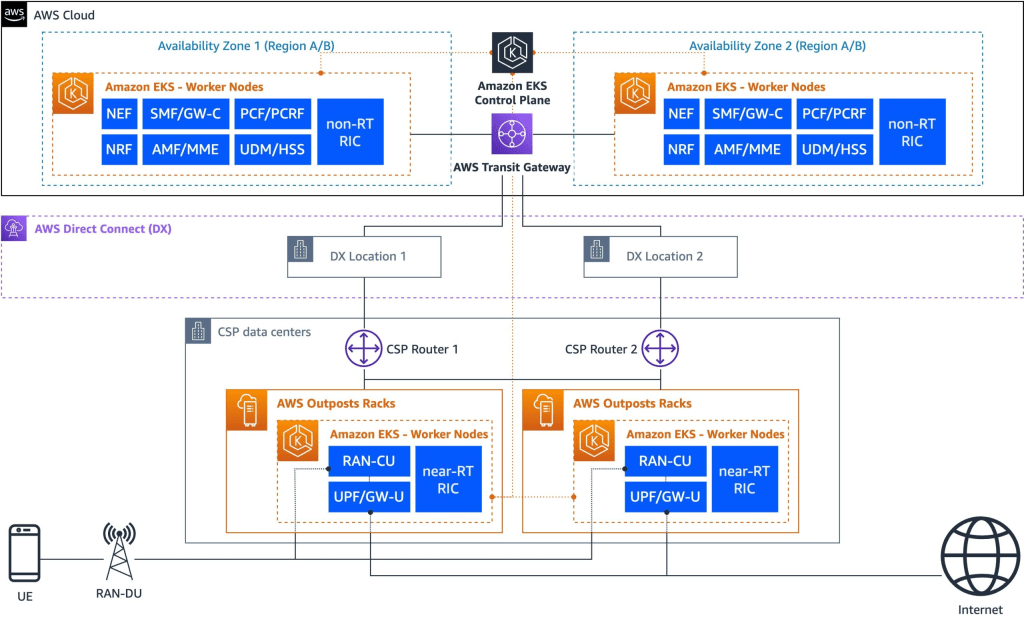

Tình huống 7: Triển khai lõi gói kết hợp với RAN CU và RIC

Kịch bản này tương tự như Tình huống 1, trong đó mặt phẳng điều khiển lõi gói chạy trong AWS Region, trong khi UPF được phân phối trên nhiều Outposts ở biên. Đối với các CSP muốn triển khai RAN CU và Bộ điều khiển thông minh RAN gần thời gian thực (RIC) trong cùng một trung tâm dữ liệu biên với UPF, họ có thể sử dụng cùng một giá đỡ Outposts. Thành phần RIC không theo thời gian thực có thể được triển khai trong các AWS Region, tương tự như mặt phẳng điều khiển lõi gói, như thể hiện trong hình sau.

RAN CU chạy các giao thức quan trọng như Kiểm soát tài nguyên vô tuyến (RRC), Giao thức thích ứng dữ liệu dịch vụ (SDAP) và Giao thức hội tụ dữ liệu gói (PDCP) và nó cần giao tiếp thông lượng cao, độ trễ thấp với cả Đơn vị phân tán RAN (DU) và lõi gói. Triển khai RAN CU trên các giá đỡ Outposts với các phiên bản bmn-cx2 ở biên cho phép CSP đạt được các yêu cầu về hiệu suất trong khi vẫn duy trì tính nhất quán trong hoạt động với việc triển khai lõi gói của họ.

Triển khai RIC gần thời gian thực trên các giá đỡ Outposts cùng với RAN CU và UPF cho phép CSP triển khai các chức năng nhạy cảm với thời gian như quản lý nhiễu, quản lý chất lượng dịch vụ (QoS) và quản lý kết nối vô tuyến với độ trễ tối thiểu. Trong khi đó, RIC không theo thời gian thực được triển khai trong các AWS Region sử dụng tài nguyên điện toán quy mô đám mây để tối ưu hóa toàn mạng, sử dụng dữ liệu từ ngăn xếp OSS và áp dụng các khả năng trí tuệ nhân tạo (AI)/ML để phát triển các mô hình nâng cao hiệu suất RAN. Phương pháp triển khai phân chia này cung cấp cho CSP cả hiệu suất biên cần thiết cho các hoạt động theo thời gian thực và quy mô đám mây cần thiết để phân tích và tối ưu hóa nâng cao trong khi vẫn duy trì cơ sở hạ tầng AWS và trải nghiệm quản lý nhất quán.

Hình 7: Triển khai lõi gói kết hợp với RAN CU và RIC

Kết thúc

Các khối lượng công việc viễn thông khác nhau có các yêu cầu vị trí khác nhau, chẳng hạn như vị trí tổng hợp lưu lượng, vị trí biên và vị trí biên xa tùy thuộc vào nhu cầu phân phối lưu lượng, xử lý, quy định, tuân thủ và độ trễ. Để đáp ứng những yêu cầu này, CSP cần các giải pháp cloud nhất quán mang lại sự đơn giản trong vận hành, tính nhất quán của cơ sở hạ tầng và tính linh hoạt về kiến trúc để triển khai khối lượng công việc mạng trên các vị trí khác nhau.

Với sự sẵn sàng rộng rãi của các giá đỡ AWS Outposts mới cung cấp cho khối lượng công việc sử dụng nhiều mạng, thông lượng cao, CSP có thể đáp ứng nhu cầu hiệu suất của khối lượng công việc viễn thông bằng cách sử dụng cùng một dịch vụ và API AWS tại chỗ. Các giá đỡ AWS Outposts mới giúp CSP giải quyết sự phức tạp về triển khai, vận hành và tích hợp của việc quản lý các ngăn xếp khác nhau tại chỗ. AWS Cloud continuum cung cấp một bộ công cụ toàn diện để các CSP hiện đại hóa mạng của họ:

- AWS Telco Network Builder (TNB) hợp lý hóa việc tự động hóa và quản lý vòng đời của cơ sở hạ tầng Đám mây AWS như VPC, mạng con, cluster Amazon EKS và các worker node của Amazon EKS cho các workload 4G/5G/RAN/IMS.

- Các dịch vụ giám sát và quan sát AWS như Amazon CloudWatch, Amazon Managed Service for Prometheus và Amazon Managed Grafana cung cấp khả năng quản lý thống nhất trên toàn bộ cấu trúc liên kết mạng.

- Các dịch vụ phân tích và ML của AWS như Amazon Athena, Amazon Bedrock và Amazon SageMaker chuyển đổi mạng thành nền tảng thông minh.

Chúng tôi mời bạn khám phá cách các mẫu kiến trúc này có thể đẩy nhanh hành trình hiện đại hóa mạng của bạn. Liên hệ với nhóm khách hàng AWS của bạn ngay hôm nay để tìm hiểu thêm về Outposts dành cho khối lượng công việc sử dụng nhiều mạng, thông lượng cao.

Về các tác giả

Tiến sĩ Young Jung

Tiến sĩ Young Jung là Kiến trúc sư giải pháp chính tại Bộ phận Kinh doanh Viễn thông Toàn cầu của AWS. Là một chuyên gia trong lĩnh vực viễn thông, trọng tâm và sứ mệnh chính của ông là giúp các đối tác và khách hàng Mạng lõi/RAN (Core/RAN) viễn thông thiết kế và xây dựng các giải pháp NFV (Ảo hóa chức năng mạng) thuần đám mây trên môi trường AWS. Ông có chuyên môn sâu rộng trong việc tận dụng các dịch vụ và công nghệ của AWS để thúc đẩy quá trình chuyển đổi mạng viễn thông, đặc biệt trong các lĩnh vực sử dụng AWS Outposts để triển khai dịch vụ điện toán biên cho ngành viễn thông. Tiến sĩ Jung làm việc chặt chẽ với các nhà lãnh đạo trong ngành viễn thông để thiết kế kiến trúc và triển khai các giải pháp dựa trên đám mây tiên tiến nhằm thúc đẩy hiệu quả, sự linh hoạt và đổi mới trong lĩnh vực viễn thông.

Flo Vinti

Flo Vinti là Kiến trúc sư giải pháp cao cấp tại Bộ phận Kinh doanh Ngành Viễn thông của AWS. Với hơn một thập kỷ kinh nghiệm về công nghệ viễn thông và đám mây, Flo giúp các khách hàng viễn thông hiện đại hóa khối lượng công việc mạng và định hướng quá trình chuyển đổi lên đám mây. Chuyên môn của ông bao gồm kết nối mạng, tự động hóa và kiến trúc giải pháp đám mây.

Sigit Priyanggoro

Sigit là Kiến trúc sư giải pháp chính, tập trung vào các dịch vụ EC2 Edge. Ông làm việc ngược từ nhu cầu của khách hàng, phối hợp với các bộ phận kỹ thuật phần cứng, kỹ thuật phần mềm và kỹ thuật hệ thống trung tâm dữ liệu của AWS để đổi mới vì lợi ích của khách hàng và đối tác AWS trên toàn thế giới.

Zeb Khan

Zeb Khan là Kiến trúc sư giải pháp chính tại Bộ phận Kinh doanh Viễn thông Toàn cầu của AWS. Với hơn 18 năm kinh nghiệm trong ngành Viễn thông, ông hợp tác với khách hàng và đối tác để thiết kế kiến trúc và vận hành các khối lượng công việc Mạng lõi 5G và IMS trên quy mô lớn trên nền tảng AWS.