Tác giả: Ankur Mehrotra

Ngày phát hành: 14 JAN 2026

Chuyên mục: Amazon SageMaker AI, Artificial Intelligence

Với sự tiến bộ của các công cụ và dịch vụ giúp các mô hình AI tạo sinh trở nên dễ tiếp cận, các doanh nghiệp giờ đây có thể truy cập cùng một foundation models (FMs) như các đối thủ cạnh tranh của họ. Sự khác biệt thực sự đến từ việc xây dựng AI được tùy chỉnh cao cho doanh nghiệp của bạn—một điều mà các đối thủ cạnh tranh không thể dễ dàng sao chép. Mặc dù các FM hiện nay thực sự thông minh với kiến thức và khả năng suy luận rộng lớn, nhưng trí thông minh không có ngữ cảnh chỉ là tiềm năng. Một mô hình biết cách tư duy, nhưng nó không biết cách bạn tư duy, từ vựng của bạn, các mẫu dữ liệu của bạn, hoặc các ràng buộc trong ngành của bạn.

Việc xây dựng các mô hình hiểu sâu sắc doanh nghiệp của bạn phụ thuộc vào cách bạn làm cho mô hình học hỏi từ dữ liệu và sở thích của bạn. Các mô hình học thông qua một quy trình từng bước phản ánh cách học của con người: chúng trước tiên tiếp thu kiến thức thế giới tổng quát thông qua pre-training, sau đó có được kiến thức chuyên biệt thông qua supervised fine-tuning, và cuối cùng học cách điều chỉnh theo các sở thích cụ thể thông qua các kỹ thuật như direct preference optimization (DPO). Ở giai đoạn inference, các mô hình có thể áp dụng mọi thứ chúng đã học vào các tác vụ trong thế giới thực, và chúng có thể tiếp tục thích nghi thông qua các phương pháp hiệu quả về tham số như Low-Rank Adaptation (LoRA) mà không cần huấn luyện lại toàn bộ mô hình cơ sở.

Hành trình học tập này trải dài từ việc pre-training các FM khổng lồ đến việc tùy chỉnh chúng cho các trường hợp sử dụng cụ thể, và Amazon SageMaker AI hiện cung cấp các khả năng trên toàn bộ phổ này.

Tại AWS re:Invent 2025, Amazon SageMaker AI đã công bố những tiến bộ đáng kể làm thay đổi cách các tổ chức tiếp cận việc tùy chỉnh mô hình và huấn luyện quy mô lớn. Các khả năng mới giải quyết hai thách thức dai dẳng: sự phức tạp và thời gian cần thiết để tùy chỉnh các FM cho các trường hợp sử dụng cụ thể, và các sự cố hạ tầng tốn kém làm gián đoạn tiến độ huấn luyện kéo dài hàng tuần.

Kể từ khi ra mắt Amazon SageMaker AI vào năm 2017, chúng tôi đã cam kết làm cho việc phát triển AI trở nên dễ tiếp cận đối với các nhà phát triển ở các cấp độ kỹ năng khác nhau. Với hơn 450 khả năng được giới thiệu kể từ khi ra mắt, SageMaker AI tiếp tục loại bỏ các rào cản làm chậm đổi mới. Bài viết này khám phá cách các khả năng tùy chỉnh mô hình serverless mới, elastic training, checkpointless training và serverless MLflow hoạt động cùng nhau để tăng tốc quá trình phát triển AI của bạn từ hàng tháng xuống còn vài ngày.

Tùy chỉnh mô hình AI serverless với học tăng cường nâng cao

Khả năng tùy chỉnh mô hình serverless mới trong Amazon SageMaker AI biến một quy trình truyền thống kéo dài hàng tháng thành chỉ vài ngày. Đối với các nhà phát triển AI muốn mức độ trừu tượng cao nhất, chúng tôi đang giới thiệu một quy trình làm việc được hướng dẫn bởi tác nhân AI (trong bản xem trước) giúp việc tùy chỉnh mô hình nâng cao có thể truy cập được thông qua ngôn ngữ tự nhiên.

Thay vì yêu cầu chuyên môn sâu về các kỹ thuật học tăng cường, giờ đây bạn có thể mô tả các mục tiêu kinh doanh của mình bằng ngôn ngữ đơn giản. Tác nhân AI tham gia vào một cuộc trò chuyện đa lượt để hiểu trường hợp sử dụng của bạn, sau đó tạo ra một đặc tả toàn diện bao gồm hướng dẫn về tập dữ liệu, tiêu chí đánh giá, các chỉ số liên quan và một mô hình được đề xuất mà nhóm của bạn có thể triển khai mà không cần kiến thức chuyên biệt.

Quy trình làm việc tác nhân AI hỗ trợ supervised fine-tuning (SFT), direct preference optimization (DPO), reinforcement learning from AI feedback (RLAIF) và Reinforcement Learning from Verifiable Rewards (RLVR). Các mô hình có thể sử dụng các khả năng học tăng cường này để học hỏi từ sở thích của con người và các kết quả có thể kiểm chứng, tạo ra AI phù hợp hơn với mục tiêu kinh doanh của bạn. Bạn cũng có thể tạo dữ liệu tổng hợp khi dữ liệu thực tế bị hạn chế, phân tích chất lượng dữ liệu và xử lý huấn luyện cũng như đánh giá về độ chính xác và các kiểm soát AI có trách nhiệm. Cách tiếp cận này hoàn toàn serverless để loại bỏ sự phức tạp của hạ tầng.

Đối với các nhà phát triển AI muốn kiểm soát nhiều hơn quá trình tùy chỉnh, SageMaker AI cung cấp một giao diện đơn giản với các phương pháp hay nhất được tích hợp sẵn. Thông qua SageMaker Studio, bạn có thể chọn từ các mô hình phổ biến bao gồm Amazon Nova, Llama của Meta, Qwen, DeepSeek và GPT-OSS, sau đó chọn kỹ thuật tùy chỉnh ưa thích của bạn.

Quy trình làm việc tự hướng dẫn cung cấp sự linh hoạt ở mọi bước. Bạn có thể tải lên tập dữ liệu của riêng mình hoặc chọn từ các tập dữ liệu hiện có, cấu hình các siêu tham số như kích thước batch và tốc độ học với các giá trị mặc định được đề xuất, và chọn giữa fine-tuning hiệu quả tham số với LoRA hoặc full fine-tuning. Giao diện tích hợp với khả năng MLflow mới được giới thiệu để theo dõi thử nghiệm tự động, giúp bạn có cái nhìn rõ ràng về tiến độ huấn luyện và hiệu suất mô hình thông qua một giao diện duy nhất.

Giống như cách tiếp cận tác nhân AI, tùy chỉnh tự hướng dẫn hoàn toàn serverless. SageMaker AI tự động xử lý việc cấp phát, mở rộng và tối ưu hóa tài nguyên tính toán, vì vậy bạn có thể tập trung vào phát triển mô hình thay vì quản lý hạ tầng. Với mô hình định giá trả theo token, bạn có thể tránh được chi phí phát sinh khi chọn loại instance hoặc quản lý các cluster.

Collinear AI đã rút ngắn chu kỳ thử nghiệm của họ từ hàng tuần xuống còn vài ngày bằng cách sử dụng khả năng tùy chỉnh mô hình serverless của SageMaker AI. Soumyadeep Bakshi, Đồng sáng lập, Collinear AI, cho biết:

“Tại Collinear, chúng tôi xây dựng các tập dữ liệu được tuyển chọn và môi trường mô phỏng cho các phòng thí nghiệm AI tiên phong và các doanh nghiệp Fortune 500 để cải thiện mô hình của họ. Fine-tuning các mô hình AI là rất quan trọng để tạo ra các mô phỏng có độ trung thực cao, và trước đây nó yêu cầu phải kết nối các hệ thống khác nhau để huấn luyện, đánh giá và triển khai. Giờ đây, với khả năng tùy chỉnh mô hình serverless mới của Amazon SageMaker AI, chúng tôi có một cách thống nhất giúp chúng tôi rút ngắn chu kỳ thử nghiệm từ hàng tuần xuống còn vài ngày. Công cụ serverless end-to-end này giúp chúng tôi tập trung vào những gì quan trọng: xây dựng dữ liệu huấn luyện và mô phỏng tốt hơn cho khách hàng của chúng tôi, chứ không phải duy trì hạ tầng hay xử lý các nền tảng khác nhau.”

Kết nối tùy chỉnh mô hình và pre-training

Trong khi tùy chỉnh mô hình serverless tăng tốc phát triển cho các trường hợp sử dụng cụ thể thông qua fine-tuning và học tăng cường, các tổ chức cũng đang nhanh chóng mở rộng việc sử dụng AI tạo sinh trên nhiều bộ phận của doanh nghiệp. Các ứng dụng yêu cầu chuyên môn sâu về lĩnh vực hoặc ngữ cảnh kinh doanh cụ thể cần các mô hình thực sự hiểu kiến thức độc quyền, quy trình làm việc và các yêu cầu riêng của họ. Các kỹ thuật như prompt engineering và Retrieval Augmented Generation (RAG) hoạt động tốt cho nhiều trường hợp sử dụng, nhưng chúng có những hạn chế cơ bản khi nhúng kiến thức chuyên biệt vào sự hiểu biết cốt lõi của mô hình. Khi các tổ chức cố gắng tùy chỉnh sâu hơn thông qua continued pre-training (CPT) chỉ sử dụng dữ liệu độc quyền của họ, họ thường gặp phải hiện tượng quên thảm khốc (catastrophic forgetting), nơi các mô hình mất đi các khả năng nền tảng khi chúng học nội dung mới.

Amazon SageMaker AI hỗ trợ toàn bộ phổ phát triển mô hình, từ tùy chỉnh serverless với học tăng cường nâng cao, đến xây dựng các mô hình tiên phong từ các checkpoint ban đầu. Đối với các tổ chức có dữ liệu độc quyền cần các mô hình có chuyên môn sâu về lĩnh vực vượt xa những gì tùy chỉnh đơn thuần có thể cung cấp, chúng tôi gần đây đã giới thiệu một khả năng mới giải quyết các hạn chế của các phương pháp truyền thống trong khi vẫn bảo toàn các khả năng mô hình nền tảng.

Tuần trước, chúng tôi đã giới thiệu Amazon Nova Forge. Có thể truy cập trên Amazon SageMaker AI, dịch vụ mới này mang đến cho các nhà phát triển AI cơ hội xây dựng các mô hình tiên phong của riêng họ bằng cách sử dụng Amazon Nova. Bạn có thể sử dụng Nova Forge để bắt đầu phát triển mô hình từ các checkpoint ban đầu qua các giai đoạn pre-training, mid-training và post-training—điều này có nghĩa là bạn có thể can thiệp ở giai đoạn tối ưu thay vì chờ đợi cho đến khi quá trình huấn luyện hoàn tất. Bạn có thể kết hợp dữ liệu độc quyền của mình với dữ liệu được tuyển chọn của Amazon Nova trong suốt các giai đoạn huấn luyện bằng cách sử dụng các công thức đã được chứng minh trên hạ tầng được quản lý hoàn toàn của SageMaker AI. Cách tiếp cận trộn dữ liệu này giảm đáng kể hiện tượng quên thảm khốc so với việc huấn luyện chỉ với dữ liệu thô. Điều này giúp bảo toàn các kỹ năng nền tảng, bao gồm trí thông minh cốt lõi, khả năng tuân thủ hướng dẫn chung và lợi ích an toàn trong khi kết hợp kiến thức chuyên biệt của bạn. Nova Forge là cách đơn giản và hiệu quả nhất về chi phí để xây dựng mô hình tiên phong của riêng bạn.

Video sau đây giới thiệu Amazon Nova Forge.

Nova Forge được thiết kế cho các tổ chức có quyền truy cập vào dữ liệu độc quyền hoặc dữ liệu chuyên ngành muốn xây dựng AI thực sự hiểu lĩnh vực của họ, bao gồm:

- Sản xuất và tự động hóa – Xây dựng các mô hình hiểu dữ liệu quy trình và thiết bị chuyên biệt

- Nghiên cứu và phát triển – Tạo các mô hình được huấn luyện trên dữ liệu nghiên cứu độc quyền

- Nội dung và truyền thông – Phát triển các mô hình hiểu giọng văn thương hiệu và tiêu chuẩn nội dung

- Các ngành công nghiệp chuyên biệt – Huấn luyện các mô hình về thuật ngữ, quy định và các phương pháp hay nhất của ngành

Các công ty như Nomura Research Institute đang sử dụng Amazon Nova Forge để xây dựng các large language models (LLMs) chuyên biệt theo ngành bằng cách kết hợp dữ liệu được tuyển chọn của Amazon Nova với các tập dữ liệu độc quyền của họ.

Takahiko Inaba, Trưởng bộ phận AI và Giám đốc điều hành, Nomura Research Institute, Ltd., cho biết:

“Nova Forge cho phép chúng tôi xây dựng các LLM chuyên biệt theo ngành như một giải pháp thay thế hấp dẫn cho các mô hình mã nguồn mở. Chạy trên SageMaker AI với hạ tầng huấn luyện được quản lý, chúng tôi có thể phát triển hiệu quả các mô hình chuyên biệt như LLM dịch vụ tài chính Nhật Bản của chúng tôi bằng cách kết hợp dữ liệu được tuyển chọn của Amazon Nova với các tập dữ liệu độc quyền của chúng tôi.”

Elastic training để quản lý tài nguyên thông minh ở quy mô lớn

Nhu cầu về bộ tăng tốc AI liên tục biến động khi các workload inference mở rộng theo lưu lượng truy cập, các thử nghiệm hoàn thành giải phóng tài nguyên và các job huấn luyện mới thay đổi ưu tiên. Các workload huấn luyện truyền thống vẫn bị khóa vào phân bổ tài nguyên tính toán ban đầu của chúng, không thể tận dụng dung lượng nhàn rỗi nếu không có sự can thiệp thủ công—một quy trình tiêu tốn hàng giờ thời gian kỹ thuật của bạn mỗi tuần.

Elastic training trên Amazon SageMaker HyperPod thay đổi động lực này. Các job huấn luyện giờ đây tự động mở rộng quy mô dựa trên khả năng sẵn có của tài nguyên tính toán, mở rộng để hấp thụ các bộ tăng tốc AI nhàn rỗi và tối đa hóa việc sử dụng hạ tầng. Khi các workload ưu tiên cao hơn như inference hoặc đánh giá cần tài nguyên, quá trình huấn luyện sẽ giảm quy mô một cách linh hoạt để tiếp tục với ít tài nguyên hơn thay vì dừng hoàn toàn.

Kiến trúc kỹ thuật duy trì chất lượng huấn luyện trong suốt quá trình chuyển đổi quy mô bằng cách bảo toàn kích thước batch toàn cầu và tốc độ học trên các cấu hình song song dữ liệu khác nhau. Điều này hỗ trợ các thuộc tính hội tụ nhất quán bất kể quy mô hiện tại. Operator huấn luyện của SageMaker HyperPod điều phối các quyết định mở rộng quy mô thông qua tích hợp với control plane của Kubernetes, liên tục giám sát trạng thái cluster thông qua các sự kiện vòng đời pod, thay đổi khả năng sẵn có của node và tín hiệu ưu tiên của bộ lập lịch tài nguyên.

Việc bắt đầu rất đơn giản. Các công thức SageMaker HyperPod elastic mới cho các FM có sẵn công khai bao gồm Llama của Meta và GPT-OSS không yêu cầu thay đổi mã—chỉ cần cập nhật cấu hình YAML để chỉ định chính sách elastic.

Salesforce đang sử dụng elastic training để tự động mở rộng quy mô workload và hấp thụ các GPU nhàn rỗi khi chúng có sẵn, giải thích rằng elastic training “sẽ cho phép các workload của chúng tôi tự động mở rộng quy mô để hấp thụ các GPU nhàn rỗi khi chúng có sẵn và nhường tài nguyên một cách liền mạch, tất cả mà không làm gián đoạn chu kỳ phát triển. Quan trọng nhất, nó sẽ giúp chúng tôi tiết kiệm hàng giờ dành cho việc cấu hình lại các job thủ công để phù hợp với tài nguyên tính toán có sẵn, thời gian mà chúng tôi có thể tái đầu tư vào đổi mới.”

Giảm thiểu thời gian ngừng hoạt động phục hồi với checkpointless training

Các sự cố hạ tầng từ lâu đã là kẻ thù của tiến bộ trong huấn luyện quy mô lớn. Các lần huấn luyện kéo dài hàng tuần có thể bị gián đoạn bởi một lỗi node duy nhất, buộc bạn phải khởi động lại từ checkpoint cuối cùng và mất hàng giờ hoặc hàng ngày thời gian GPU đắt đỏ. Phục hồi dựa trên checkpoint truyền thống bao gồm các giai đoạn tuần tự—chấm dứt và khởi động lại job, khám phá quy trình và thiết lập mạng, truy xuất checkpoint, khởi tạo lại ngữ cảnh GPU và tiếp tục vòng lặp huấn luyện. Khi xảy ra lỗi, toàn bộ cluster phải chờ mọi giai đoạn hoàn tất trước khi quá trình huấn luyện có thể tiếp tục.

Checkpointless training trên Amazon SageMaker HyperPod loại bỏ nút thắt này. Hệ thống duy trì bảo toàn trạng thái mô hình liên tục trên các cluster phân tán, tự động hoán đổi các thành phần bị lỗi và phục hồi quá trình huấn luyện thông qua truyền trạng thái mô hình ngang hàng từ các bộ tăng tốc AI khỏe mạnh. Khi xảy ra lỗi hạ tầng, quá trình phục hồi diễn ra trong vài giây mà không cần can thiệp thủ công. Video sau đây giới thiệu checkpointless training.

Điều này có nghĩa là đạt được goodput huấn luyện lên tới 95% trên các cluster có hàng nghìn bộ tăng tốc AI, tức là hạ tầng tính toán được sử dụng tích cực cho các job huấn luyện lên đến 95% thời gian. Giờ đây, bạn có thể tập trung vào đổi mới thay vì quản lý hạ tầng, đẩy nhanh thời gian đưa sản phẩm ra thị trường hàng tuần.

Intercom đã tích hợp checkpointless training vào các pipeline của họ để loại bỏ việc phục hồi checkpoint thủ công, cho biết:

“Tại Intercom, chúng tôi liên tục huấn luyện các mô hình mới để cải thiện Fin, và chúng tôi rất vui mừng được tích hợp checkpointless training vào các pipeline của mình. Điều này sẽ loại bỏ hoàn toàn nhu cầu phục hồi checkpoint thủ công. Kết hợp với elastic training, nó sẽ cho phép chúng tôi cung cấp các cải tiến cho Fin nhanh hơn và với chi phí hạ tầng thấp hơn.”

Serverless MLflow: Khả năng quan sát cho mọi nhà phát triển AI

Dù tùy chỉnh mô hình hay huấn luyện ở quy mô lớn, bạn đều cần các khả năng để theo dõi thử nghiệm, quan sát hành vi và đánh giá hiệu suất. Tuy nhiên, việc quản lý hạ tầng MLflow theo truyền thống yêu cầu quản trị viên phải liên tục duy trì và mở rộng các máy chủ theo dõi, đưa ra các quyết định lập kế hoạch dung lượng phức tạp và triển khai các instance riêng biệt để cách ly dữ liệu. Gánh nặng hạ tầng này làm chuyển hướng tài nguyên khỏi việc phát triển AI cốt lõi.

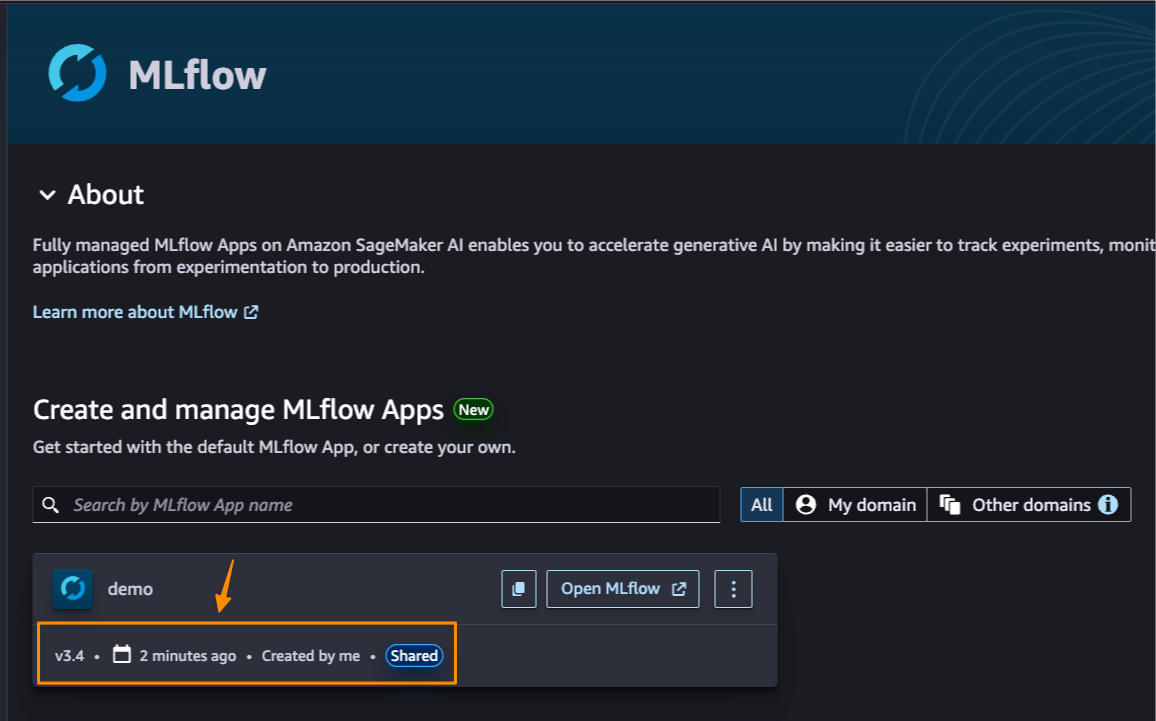

Amazon SageMaker AI hiện cung cấp khả năng MLflow serverless giúp loại bỏ sự phức tạp này. Bạn có thể bắt đầu theo dõi, so sánh và đánh giá các thử nghiệm mà không cần chờ thiết lập hạ tầng. MLflow tự động mở rộng quy mô để mang lại hiệu suất nhanh chóng cho các tác vụ phát triển mô hình đòi hỏi cao và khó đoán, sau đó giảm quy mô trong thời gian nhàn rỗi. Ảnh chụp màn hình sau đây hiển thị ứng dụng MLflow trong giao diện người dùng SageMaker AI.

Khả năng này hoạt động nguyên bản với tùy chỉnh mô hình serverless của Amazon SageMaker AI để bạn có thể hình dung các job huấn luyện và đánh giá đang diễn ra thông qua một giao diện duy nhất. Các khả năng tracing nâng cao giúp nhanh chóng xác định lỗi hoặc hành vi không mong muốn trong các quy trình làm việc tác nhân và các ứng dụng đa bước. Các nhóm có thể sử dụng MLflow Prompt Registry để quản lý phiên bản, theo dõi và tái sử dụng các prompt trong toàn tổ chức, duy trì tính nhất quán và cải thiện sự hợp tác.

Tích hợp với SageMaker Model Registry cung cấp quản trị mô hình liền mạch, tự động đồng bộ hóa các mô hình được đăng ký trong MLflow với vòng đời sản xuất. Sau khi các mô hình đạt được mục tiêu độ chính xác và hiệu suất mong muốn, bạn có thể triển khai chúng đến các endpoint inference của SageMaker AI chỉ với vài cú nhấp chuột.

Quản trị viên có thể giúp nâng cao năng suất bằng cách thiết lập quyền truy cập liên tài khoản bằng cách sử dụng AWS Resource Access Manager (AWS RAM) để đơn giản hóa sự hợp tác giữa các ranh giới tổ chức. Khả năng MLflow serverless được cung cấp miễn phí và tự động nâng cấp lên phiên bản MLflow mới nhất, giúp bạn truy cập các tính năng mới nhất mà không cần thời gian bảo trì hoặc nỗ lực di chuyển.

Wildlife Conservation Society đang sử dụng khả năng serverless mới để nâng cao năng suất và tăng tốc thời gian thu thập thông tin chi tiết. Kim Fisher, Kỹ sư phần mềm trưởng MERMAID, WCS, cho biết:

“WCS đang thúc đẩy bảo tồn rạn san hô toàn cầu thông qua MERMAID, một nền tảng mã nguồn mở sử dụng các mô hình ML để phân tích ảnh rạn san hô từ các nhà khoa học trên khắp thế giới. Amazon SageMaker với MLflow đã nâng cao năng suất của chúng tôi bằng cách loại bỏ nhu cầu cấu hình máy chủ theo dõi MLflow hoặc quản lý dung lượng khi nhu cầu hạ tầng của chúng tôi thay đổi. Bằng cách cho phép nhóm của chúng tôi tập trung hoàn toàn vào đổi mới mô hình, chúng tôi đang tăng tốc thời gian triển khai để cung cấp những thông tin chi tiết quan trọng dựa trên đám mây cho các nhà khoa học và quản lý biển.”

Tăng tốc đổi mới AI ở mọi cấp độ

Những thông báo này không chỉ đại diện cho những cải tiến tính năng riêng lẻ—chúng thiết lập một hệ thống toàn diện cho việc phát triển mô hình AI, đáp ứng các nhà phát triển ở bất cứ đâu trên hành trình của họ. Từ tùy chỉnh được hướng dẫn bằng ngôn ngữ tự nhiên đến các quy trình làm việc tự định hướng, từ quản lý tài nguyên thông minh đến huấn luyện chịu lỗi, từ theo dõi thử nghiệm đến triển khai sản xuất, Amazon SageMaker AI cung cấp bộ công cụ hoàn chỉnh để biến ý tưởng AI thành hiện thực sản xuất.

Bắt đầu

Các khả năng tùy chỉnh mô hình SageMaker AI và SageMaker HyperPod mới hiện có sẵn tại các AWS Regions trên toàn thế giới. Khách hàng SageMaker AI hiện tại có thể truy cập các tính năng này thông qua bảng điều khiển SageMaker AI, và khách hàng mới có thể bắt đầu với AWS Free Tier.

Để biết thêm thông tin về các khả năng mới nhất của Amazon SageMaker AI, hãy truy cập aws.amazon.com/sagemaker/ai.

Về tác giả

Ankur Mehrotra gia nhập Amazon vào năm 2008 và hiện là Tổng Giám đốc của Amazon SageMaker AI. Trước Amazon SageMaker AI, ông đã làm việc để xây dựng các hệ thống quảng cáo và công nghệ định giá tự động của Amazon.com.